四位少女,借助AI绘画在ChatGPT的浪潮中崭露头角,以新颖“魔法”瞬间吸引众人目光。

原本是一张四个闺蜜在沙滩边的普通合影,在新魔法的加持下,“啪”地一下画风突变,瞬间转化为唯美动漫风格。不仅如此,还有多种效果展示,例如另一种风格转换:

这种效果不仅令人惊艳,而且保持了人物姿势的“原汁原味”,让美女们轻松实现动漫自由。此等创意引发网友围观,纷纷直呼“在线求教程”。

有网友呼吁可将此玩法商业化,而这一切的幕后英雄是一位名叫“viggo”的华人小哥博主。他左手StableDiffusion,右手ControlNet,两大法宝助他实现这一创意。

StableDiffusion作为大家熟知的AI作画神器,能根据输入文本快速生成图片。而ControlNet则是新晋当红AI插件(GitHub上线2天狂揽4.6K星),为AI作画加上buff,可精准控制手部细节和整体结构等。

小哥的做法相对简单:先将原图导入,用StableDiffusion将图片转化为文字,再用Text2Prompt插件拓展找到对应关键词,最后用ControlNet插件绑定骨骼开始换关键词试效果。

当然,原图中四位美女的姿势也可根据小哥绘制的骨骼结构进行改变。例如这样的变化:

相比原图中人物的位置,上面这张中的人物更分散且站成一排,同时上半身手臂的姿势也发生了变化。得益于StableDiffusion的能力,AI生成画作在画风上也能产出截然不同的效果。

效果之惊艳,已有网友照着小哥的说法“复现”了一遍,并表示:“第一次接触,很好玩,尝试复现下,感觉良好。”不过ControlNet的“神通”可不仅限于此。例如微博博主“海辛Hyacinth”便分享了他用ControlNet插件后“草图变美女”的玩法。

他先是绘制了一张线稿:

然后开启了ControlNet的scribble模细化效果,得到了这样的结果:

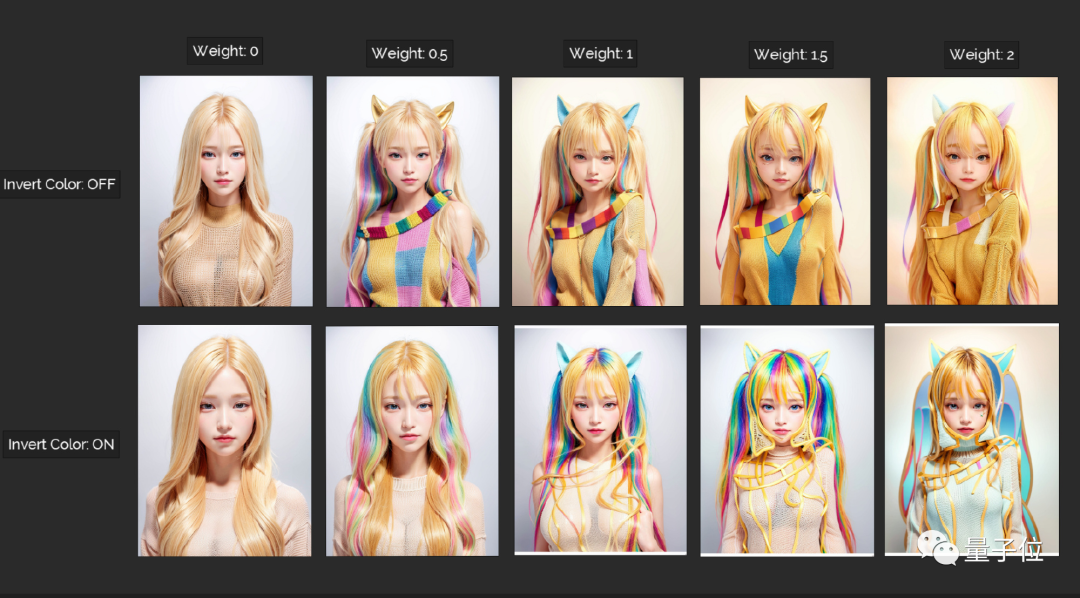

效果之逼真,令人叹服。“海辛Hyacinth”还测试了同一seed下不同参数的效果:

有小伙伴问,如果关闭ControlNet,效果会怎样?博主也做了测试,效果如下:

“海辛Hyacinth”的这波操作也得到了ControlNet作者的认可:

这也让博主激动不已,直呼“尖叫”。当然,ControlNet还可实现诸多其他功能,例如在装修设计上,输入一张拍好的卧室图,即可输出草图和换了风格的效果图:

此外,在ControlNet的在线网站中也提供了许多不同功能的玩法体验,感兴趣的小伙伴可以去尝试。

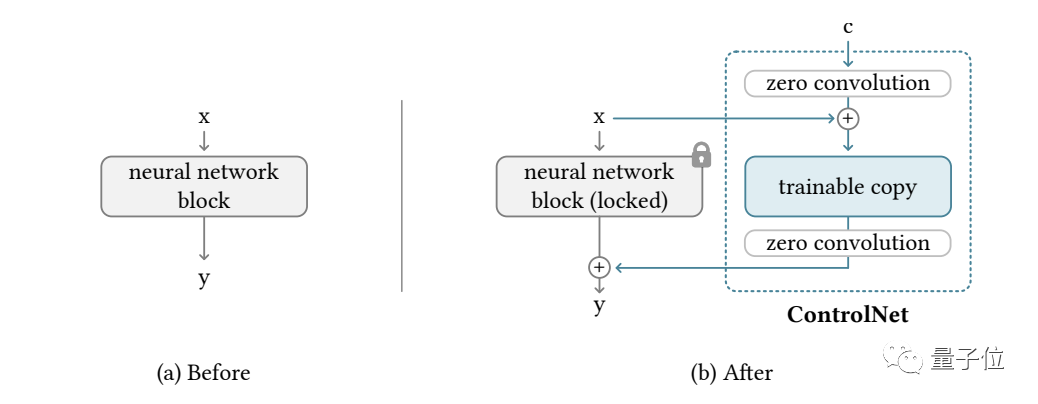

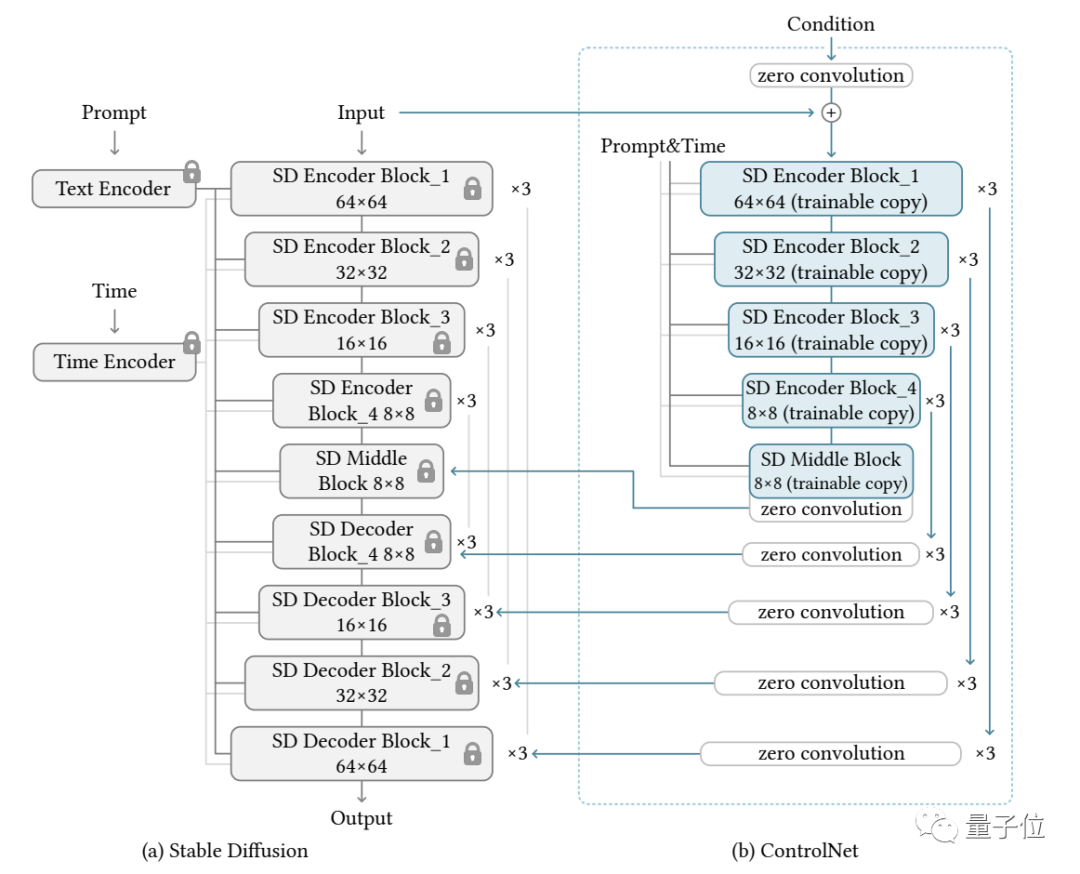

ControlNet的原理本质上是给预训练扩散模型增加一个额外的输入,控制它生成的细节。这里可以是各种类型输入,作者给出了8种,包括草图、边缘图像、语义分割图像等。那么,让大模型学会“按输入条件生成图片”的原理是什么呢?ControlNet整体思路和架构分工如下:

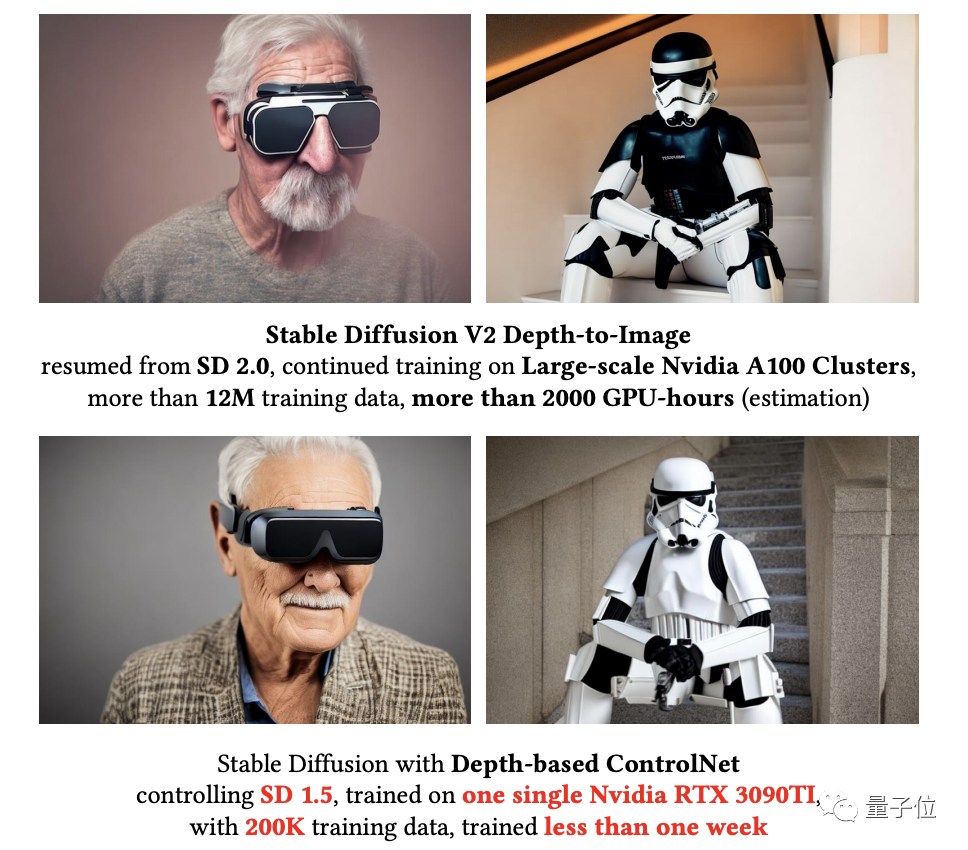

具体来说,ControlNet先复制一遍扩散模型的权重,得到一个“可训练副本”。相比之下,原扩散模型经过几十亿张图片的预训练,参数被“锁定”。而这个“可训练副本”只需在特定任务的小数据集上训练即可学会条件控制。据作者表示,即使数据量很少(不超过5万张图片),模型经过训练后条件控制生成的效果也很好。“锁定模型”和“可训练副本”通过一个1×1的卷积层连接,名叫“0卷积层”。0卷积层的权重和偏置初始化为0,这样在训练时速度会非常快,接近微调扩散模型的速度,甚至在个人设备上训练也可以。例如一块英伟达RTX 3090TI,用20万张图像数据训练的话只需不到一个星期:

作者基于当前大火的Stable Diffusion进行了具体实现,主要架构如下:

针对不同的输入,作者也给出了对应不同的模型,生成效果都相当不错。具体效果就如我们之前所展示的那样。最后温馨提示:男同胞们情人节过后可别放松警惕哦!接下来还可能有白色情人节(3月14日)、黑色情人节(4月14日)等节日。赶紧把这套“AI组合拳”学起来送自己的老婆/女朋友一张唯美的礼物吧!